重新定义「小版本」!全面实测新版 DeepSeek R1,我们挖出了这些隐藏亮点

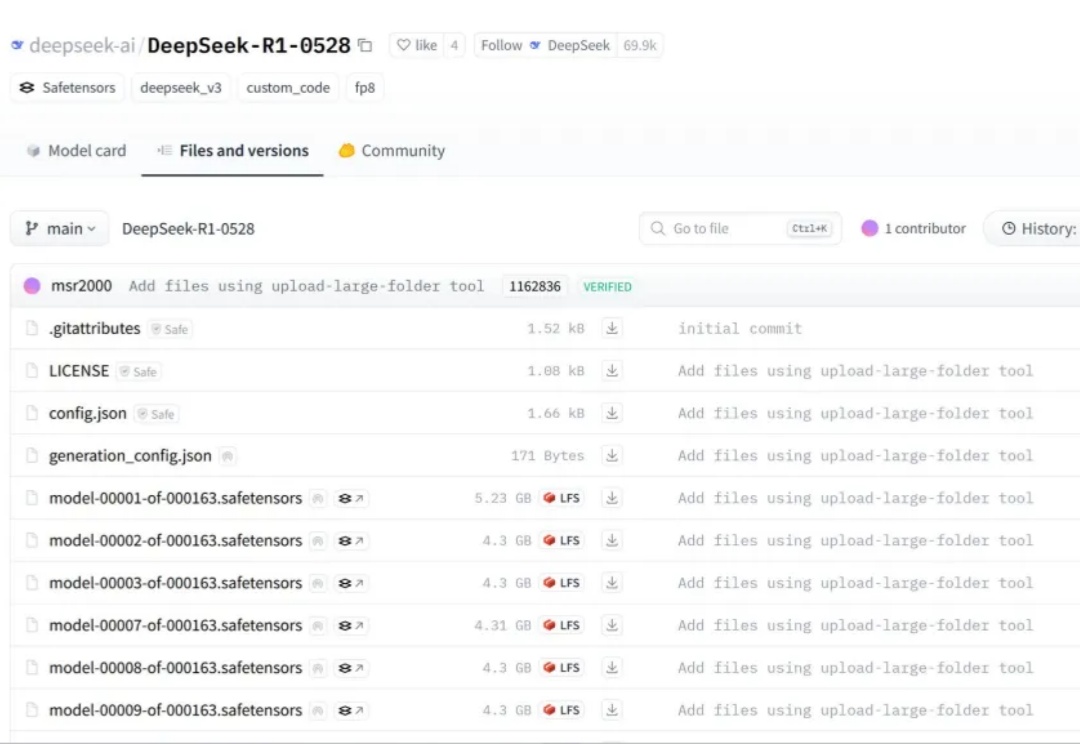

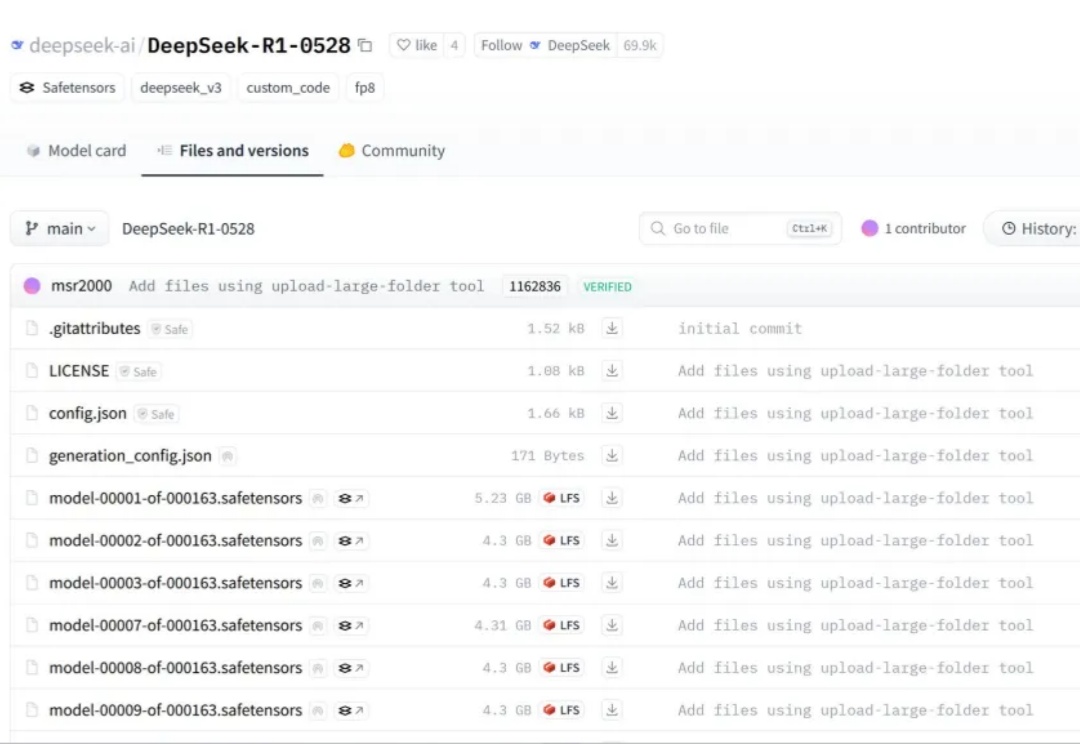

重新定义「小版本」!全面实测新版 DeepSeek R1,我们挖出了这些隐藏亮点DeepSeek 猝不及防地更新了,不是 R2,而是 R1 v2。

DeepSeek 猝不及防地更新了,不是 R2,而是 R1 v2。

近半年来,OpenAI 形象开始变得灰暗: 团队骨干相继离职引发猜疑、组织转型遭受口诛笔伐、GPT-4.5/Sora 等模型表现不及预期,还有被 DeepSeek R1 打破的叙事神话……

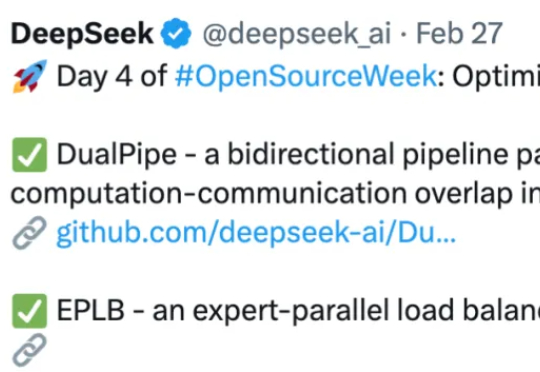

在今年 2 月的 DeepSeek 开源周中,大模型推理过程中并行策略和通信效率的深度优化成为重点之一。在今年 2 月的 DeepSeek 开源周中,大模型推理过程中并行策略和通信效率的深度优化成为重点之一。

当技术范式重构,强者也不得不重新起跑。

随着 Deepseek 等强推理模型的成功,强化学习在大语言模型训练中越来越重要,但在视频生成领域缺少探索。复旦大学等机构将强化学习引入到视频生成领域,经过强化学习优化的视频生成模型,生成效果更加自然流畅,更加合理。并且分别在 VDC(Video Detailed Captioning)[1] 和 VBench [2] 两大国际权威榜单中斩获第一。

新芒xAI今天注意到,备受关注的全球顶级域名 AI.com 跳转目标近日发生变更。目前访问 AI.com 会跳转至一个全新的、充满神秘感的网站。此前该域名曾指向人工智能初创公司 DeepSeek 的相关页面,但根据最新观察,AI.com 现已解绑 DeepSeek。

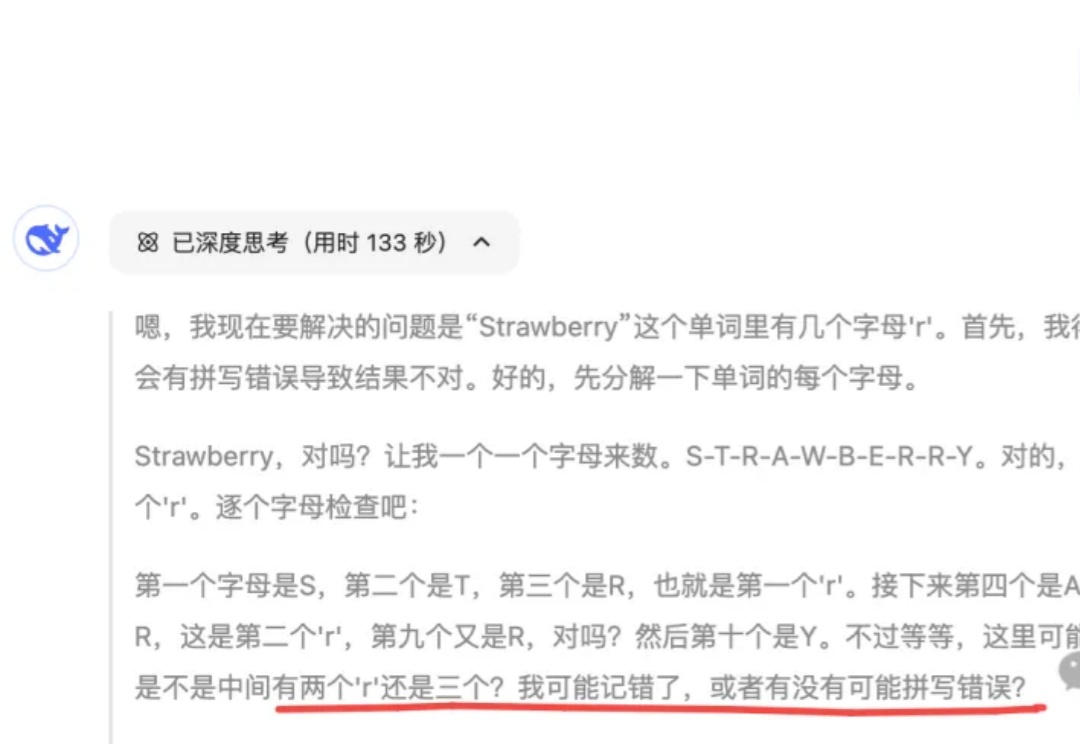

最近,我撞见了一个 DeepSeek 又“认真”又“拧巴”的怪异场景。

就在昨天,深耕语音、认知智能几十年的科大讯飞,发布了全新升级的讯飞星火推理模型 X1。不仅效果上比肩 DeepSeek-R1,而且我注意到一条官方发布的信息——基于全国产算力训练,在模型参数量比业界同类模型小一个数量级的情况下,整体效果能对标 OpenAI o1 和 DeepSeek R1。

继接入 DeepSeek 后,APPSO 发现名为「元宝」的 AI 助手目前已经正式入驻微信。现在,你可以在微信框搜索「元宝」,亦或者直接扫描二维码图片,将其添加到通讯录,即可与它展开对话。

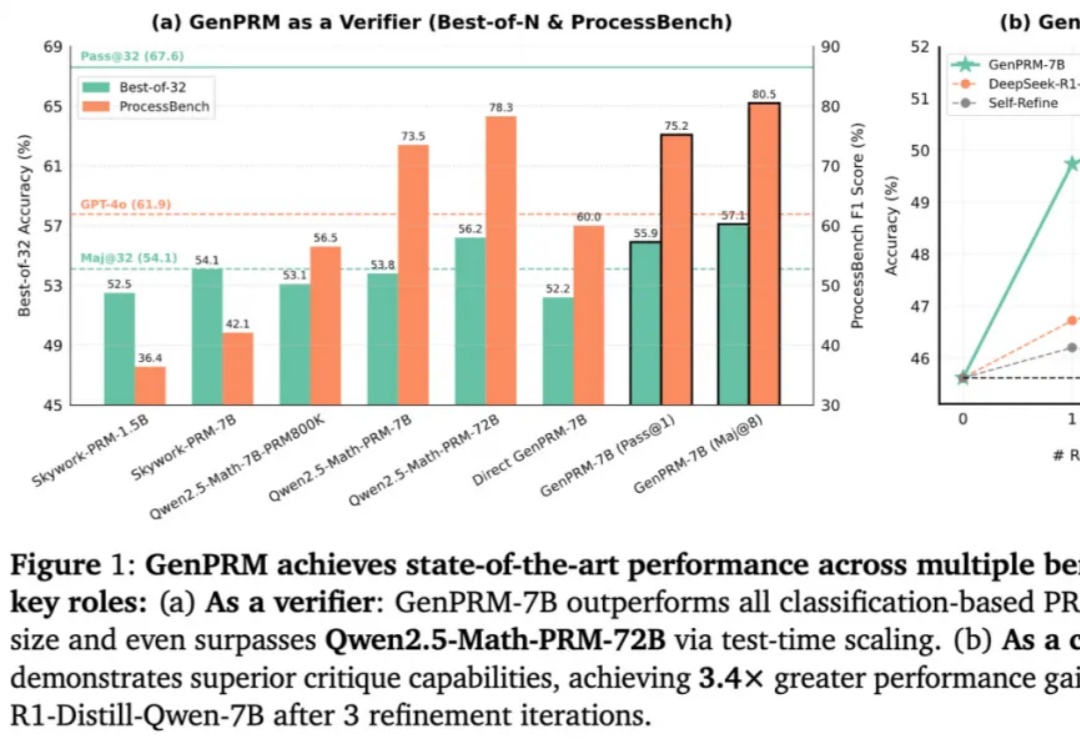

随着 OpenAI o1 和 DeepSeek R1 的爆火,大语言模型(LLM)的推理能力增强和测试时扩展(TTS)受到广泛关注。然而,在复杂推理问题中,如何精准评估模型每一步回答的质量,仍然是一个亟待解决的难题。传统的过程奖励模型(PRM)虽能验证推理步骤,但受限于标量评分机制,难以捕捉深层逻辑错误,且其判别式建模方式限制了测试时的拓展能力。